Sitemize üye olarak beğendiğiniz içerikleri favorilerinize ekleyebilir, kendi ürettiğiniz ya da internet üzerinde beğendiğiniz içerikleri sitemizin ziyaretçilerine içerik gönder seçeneği ile sunabilirsiniz.

Zaten bir üyeliğiniz mevcut mu ? Giriş yapın

Sitemize üye olarak beğendiğiniz içerikleri favorilerinize ekleyebilir, kendi ürettiğiniz ya da internet üzerinde beğendiğiniz içerikleri sitemizin ziyaretçilerine içerik gönder seçeneği ile sunabilirsiniz.

Üyelerimize Özel Tüm Opsiyonlardan Kayıt Olarak Faydalanabilirsiniz

- Anasayfa

- Uygulamalar

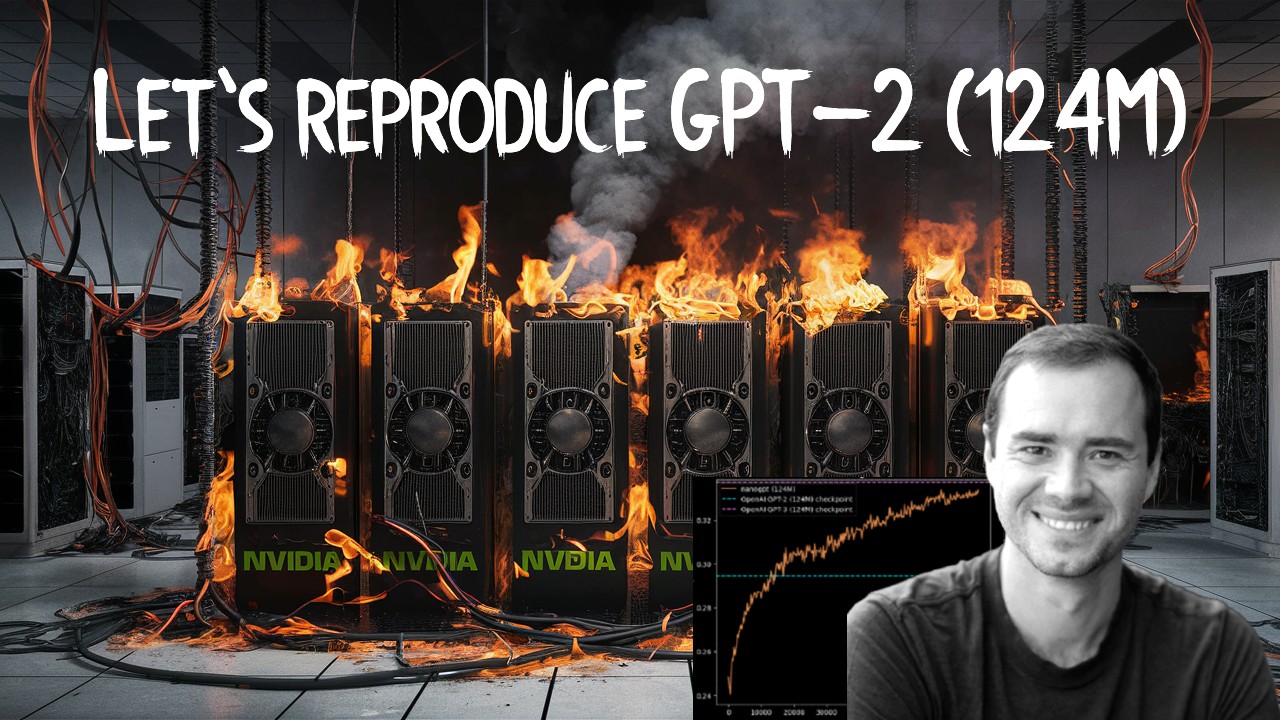

- OpenAI’nin Kurucu Ortağı Andrej Karpathy’den Kapsamlı Sunum: GPT-2 (124M) Modelinin Yeniden Üretilmesi

OpenAI’nin Kurucu Ortağı Andrej Karpathy’den Kapsamlı Sunum: GPT-2 (124M) Modelinin Yeniden Üretilmesi

Teknoloji dünyasında en popüler gelişmelerden biri, OpenAI’nin 2019 yılında yayınladığı GPT-2 dil modeli oldu. Bu model, doğal dil işleme alanında büyük bir atılım gerçekleştirerek araştırmacıların ilgisini çekmeyi başardı. Şimdi ise OpenAI’nin kurucu ortağı Andrej Karpathy, bu modelin en büyük versiyonu olan 124 milyon parametreli GPT-2 modelini yeniden üretme çalışmasına dair kapsamlı bir sunum gerçekleştirdi.

Karpathy, videosunda GPT-2 mini serilerindeki farklı boyutlardaki modellerin performanslarını detaylı bir şekilde ele aldı. GPT-2 mini serileri, 117M, 345M, 774M ve 1.5B parametreli modeller olmak üzere çeşitli boyutlardaki ağları içeriyor. En büyüğü “GPT-2” olarak adlandırılan 1.5 milyar parametreli model, doğal dil işleme görevlerinde en yüksek başarıyı gösteriyor.

Karpathy, model boyutu arttıkça dil anlama, çeviri, özetleme ve soru cevaplama gibi alanlardaki performansların da belirgin şekilde yükseldiğini vurguladı. Örneğin, en küçük model olan GPT-2 Small, metin üretiminde daha kısa ve basit cümleler oluştururken, GPT-2 124M modeli daha uzun, karmaşık ve tutarlı metinler üretiyor. Büyük modeller ayrıca soru cevaplama, özetleme ve çeviri konularında da daha başarılı sonuçlar elde ediyor.

GPT-2 124M modeli, 12 katmandan ve 768 boyutlu gizli katmanlardan oluşuyor. Karpathy, bu modelin günümüzde yaklaşık 1 saatte ve 10 dolarlık bir maliyet ile yeniden üretilebileceğini belirtti. OpenAI’nin orijinal ağırlıklarının da mevcut olduğunu, ancak eğitim detaylarının tam olarak paylaşılmadığını, bu nedenle GPT-3 makalesinden de yararlanacaklarını söyledi.

Modelin ağırlıklarını inceleyerek, konum gömüleri ve katman ağırlıklarındaki ilginç yapıları analiz eden Karpathy, daha sonra modelin Hugging Face Transformers kütüphanesi üzerinden yüklenerek örnek metin üretimini gerçekleştirdi. Bu süreçte, model parametrelerindeki yapıları ve değişimleri detaylı bir şekilde inceledi.

Karpathy, videoda ayrıca GPT-2 modelinin mimarisini Transformer mimarisine göre açıklayarak, model blokları ve katmanlar arasındaki farkları da detaylandırdı. Transformer mimarisindeki encoder kısmının GPT-2’de olmadığını, ayrıca layer normalizasyon işlemlerinin de farklı konumlarda yapıldığını vurguladı.

class Transformer(nn.Module): def __init__(self): super().__init__() self.wte = nn.Embedding(50257, 768) # Token embeddings self.wpe = nn.Embedding(1024, 768) # Position embeddings self.h = nn.ModuleList([Block() for _ in range(12)]) # 12 Transformer blocks self.ln_f = nn.LayerNorm(768, eps=1e-5) self.lm_head = nn.Linear(768, 50257, bias=False) Karpathy, daha sonra kendi GPT-2 sınıfını oluşturmaya ve OpenAI’nin ağırlıklarını bu sınıfa yükleyerek, modelin önce orijinal performansını yakalamayı, ardından da kendi eğitimleriyle daha iyi sonuçlar elde etmeyi hedeflediklerini belirtti.

Uzmanlar, Karpathy’nin bu kapsamlı çalışmasının, derin öğrenme ve doğal dil işleme alanlarındaki araştırmacılar için önemli bir kaynak olacağını değerlendiriyor. Özellikle modelin mimarisi, eğitimi ve ağırlık yapılarının incelenmesi, bu alanda çalışan bilim insanlarına yol gösterici olacak.

GPT-2 Mini Serilerindeki Performans Farklılıkları

Karpathy, GPT-2 mini serilerindeki farklı boyutlardaki modellerin doğal dil işleme görevlerindeki performans özelliklerini detaylı bir şekilde inceledi. Buna göre, model boyutu arttıkça dil anlama, çeviri, özetleme ve soru cevaplama gibi alanlardaki başarı oranları da belirgin şekilde yükseliyor.

En küçük model olan GPT-2 Small, metin üretiminde daha kısa ve basit cümleler oluştururken, GPT-2 124M modeli daha uzun, karmaşık ve tutarlı metinler üretiyor. Ayrıca, büyük modellerin soru cevaplama, özetleme ve çeviri gibi görevlerde de daha başarılı olduğu gözlemlendi.

Karpathy, model boyutlarındaki artışın doğal dil işleme performansını önemli ölçüde geliştirdiğini vurguladı. Özellikle GPT-2 124M modelinin, OpenAI’nin diğer güncel modellerine kıyasla daha güçlü özelliklere sahip olduğu ifade edildi.

Modelin Yeniden Üretimi ve Ağırlık Yapısının İncelenmesi

Karpathy, OpenAI’nin orijinal ağırlıklarını kullanarak GPT-2 124M modelini yeniden üretmeyi hedeflediklerini söyledi. Ancak, eğitim detaylarının tam olarak paylaşılmadığını belirterek, GPT-3 makalesinden de yararlanacaklarını belirtti.

Modelin ağırlıklarını inceleyerek, konum gömüleri ve katman ağırlıklarındaki ilginç yapıları analiz eden Karpathy, daha sonra modeli

Bu süreçte, model parametrelerindeki değişimleri ve yapıları detaylı bir şekilde inceledi. Karpathy, GPT-2 modelinin mimarisini Transformer mimarisine göre de açıkladı. Transformer mimarisindeki encoder kısmının GPT-2’de olmadığını, ayrıca layer normalizasyon işlemlerinin de farklı konumlarda yapıldığını vurguladı. Bu farklılıkların, modelin performansına etki ettiğini belirtti.

Karpathy, daha sonra kendi GPT-2 sınıfını oluşturmaya ve OpenAI’nin ağırlıklarını bu sınıfa yükleyerek, modelin önce orijinal performansını yakalamayı, ardından da kendi eğitimleriyle daha iyi sonuçlar elde etmeyi hedeflediklerini belirtti.

Sonuç ve Değerlendirme

Karpathy’nin bu kapsamlı sunumu, derin öğrenme ve doğal dil işleme alanlarındaki araştırmacılar için önemli bir kaynak olarak değerlendiriliyor. Özellikle GPT-2 modelinin mimarisi, eğitimi ve ağırlık yapılarının incelenmesi, bu alanda çalışan bilim insanlarına yol gösterici olacak.

Modelin boyutunun artmasıyla birlikte, doğal dil işleme görevlerindeki performansının da önemli ölçüde yükseldiği gözlemlendi. En büyük model olan GPT-2 124M, diğer güncel modellere kıyasla daha gelişmiş özelliklere sahip. Metin üretimi, soru cevaplama, özetleme ve çeviri gibi alanlarda daha başarılı sonuçlar elde ediyor.

Karpathy ve ekibi, OpenAI’nin orijinal ağırlıklarını kullanarak GPT-2 124M modelini yeniden üretme çalışmalarını sürdürüyor. Bu çalışmayla birlikte, modelin mimarisi, ağırlık yapıları ve eğitim detaylarına dair daha fazla bilgi edinilmesi bekleniyor. Böylece, derin öğrenme ve doğal dil işleme alanlarındaki araştırmacıların da bu model üzerinde daha derinlemesine çalışmalar yapabilmesi mümkün olacak.

Sonuç olarak, Andrej Karpathy’nin sunumu, GPT-2 modelinin kapsamlı bir analizini ve yeniden üretilme çabalarını gözler önüne seriyor. Bu çalışma, doğal dil işleme alanındaki ilerlemelere ışık tutacak ve araştırmacılara yol gösterici olacak nitelikte.

- Site İçi Yorumlar